Objetivos

- Proponer una nueva solución a la problemática de ejecución de programas de cómputo científico que requieren de

alta capacidad de procesamiento en el Instituto de Ingeniería.

- Evaluar el uso de clusters como alternativa viable a la problemática de ejecución de programas de cómputo científico

que requieren de sistemas de alta capacidad para procesamiento de datos dentro del Instituto de Ingeniería.

- Abrir nuevas alternativas a la adquisición de sistemas de cómputo de alto rendimiento como son los clusters, que

puedan proporcionar resultados similares a menor costo y escalables, comparables con las supercomputadoras.

- Encaminar a los investigadores del Instituto de Ingeniería al uso de nuevas tecnologías para el procesamiento de

grandes volúmenes de datos como también se hace en otros centros de investigación.

Prefacio

En temas relacionados con la ingeniería, hoy en día es común procesar grandes cantidades

de información, y es necesario emplear principalmente sistemas de cómputo rápidos

y con buenos recursos tales como procesador y memoria. En el mercado existen sistemas que

pueden ofrecer estos requerimientos; tal es el caso de las computadoras multiprocesador o

las llamadas supercomputadoras, pero este tipo de tecnología es muy costosa, tanto en el

precio como en el mantenimiento de los equipos.

Ante esta situación, se buscan soluciones que puedan proporcionar resultados similares, a menor

costo y escalables. Una de estas soluciones son los clusters.

¿Por qué darse a la tarea de diseñar y construir clusters, cuando hay supercomputadoras comerciales,

perfectamente buenas y disponibles en el mercado?. La respuesta rápida es el dinero.

Cuando se construye un cluster con hardware disponible en los centros de cómputo, los costos son menores comparados con el de una supercomputadora comercial, obteniendo resultados satisfactorios tomando en

cuenta el costo/beneficio.

Los primeros sistemas cluster fueron explorados por Don Becker y sus colegas en la NASA. Debido a que las

restricciones presupuestarias les imposibilitaban el acceso a una supercomputadora comercial,

ellos necesitaban analizar un conjunto complejo y muy grande de datos, que las misiones de la NASA

tienden a generar. Encontraron la forma de conseguir el rendimiento de cómputo que necesitaban.

Nombraron a su creación ``Beowulf`` en honor al héroe mítico inglés Beowulf![[*]](footnote.png) .

.

Los clusters asombrosamente han llegado a tener un gran alcance. Actualmente existe un listado actualizado

semestralmente por la universidad de Manhiem en Alemania que describe las mejores 500 supercomputadoras

en el mundo![[*]](footnote.png) , entre éstas figuran

algunos clusters. Hasta 1997, casi todos los sistemas enumerados eran los sistemas comerciales de supercomputadoras

de fabricantes bien conocidos tales como Cray, Silicon Graphics e IBM. A partir de 1998, algo extraordinario comenzó

a aparecer en la lista, los clusters basados en Linux.

, entre éstas figuran

algunos clusters. Hasta 1997, casi todos los sistemas enumerados eran los sistemas comerciales de supercomputadoras

de fabricantes bien conocidos tales como Cray, Silicon Graphics e IBM. A partir de 1998, algo extraordinario comenzó

a aparecer en la lista, los clusters basados en Linux.

El supercómputo también ha venido a desempeñar un papel importante en diferentes áreas como la ingeniería, química,

física, biología, cine, campo militar, entre otras y la tecnología de clusters ha llegado a ser cada vez más importante.

Es por ello que dentro de las áreas de investigación como la ingeniería no se pueden obviar estas tecnologías que

traen grandes beneficios para quienes saben aprovecharlas correctamente.

Introducción

El desarrollo de este trabajo de tesis consiste en la implementación de un cluster en el Instituto de Ingeniería de la UNAM.

Se trabajó en dos coordinaciones: Mecánica Aplicada e Ingeniería Sismológica. En ambos centros se trabaja

con grandes cantidades de información que requieren del tratamiento matemático mediante métodos numéricos que a su

vez tienen que llevarse a cabo con auxilio de sistemas de cómputo. Conforme se avanza en las investigaciones de estos

centros, es necesario de mejores y más potentes recursos de cómputo.

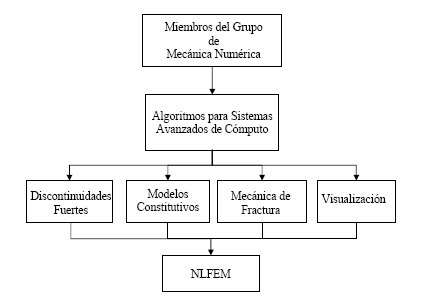

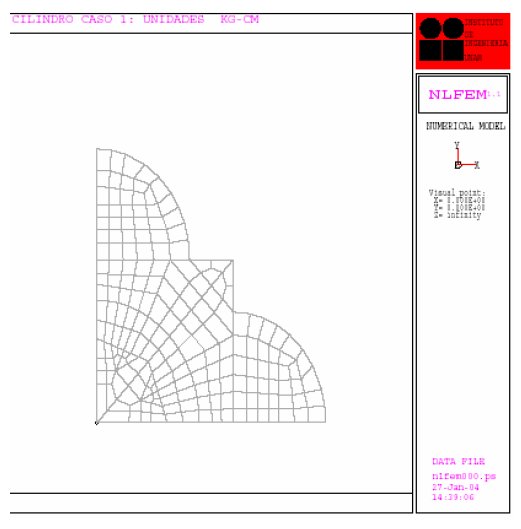

En la coordinación de Mecánica Aplicada, existe un grupo especial de mecánica numérica que dirige el Dr. Gustavo

Ayala Milián. Este grupo trabaja en proyectos donde se hace empleo de métodos numéricos avanzados aplicados a la

Ingeniería Civil que requieren de sistemas de cómputo de alto desempeño. El grupo ha trabajado con sistemas de

cómputo tradicionales, que en la mayoría de los casos les ha sido suficiente para resolver los problemas computacionales con que se han enfrentado, y es por ello que con este trabajo se pretende iniciar al grupo en el uso de las tecnologías de clusters.

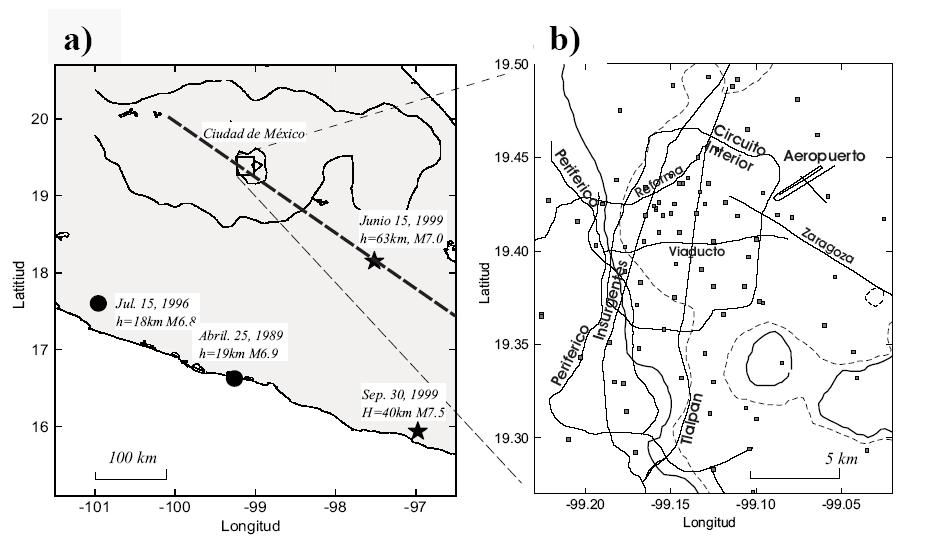

La coordinación de Ingeniería Sismológica que dirige el Dr. Jorge Aguirre González, opera y mantiene las redes

acelerográficas de campo libre y en estructuras del Instituto, y se encarga de analizar los datos colectados de

las estaciones sismográficas, lo cual requiere de sistemas de cómputo de alto desempeño para el análisis de estos

datos de una forma rápida y eficiente, por lo que un cluster es de gran utilidad para mantener operando

ininterrumpidamente la que hoy en día representa la red de monitoreo de temblores fuertes más importante del país.

Organización

La tesis esta compuesta de siete capítulos y a continuación se describe brevemente cada uno de los capítulos

contenidos en este trabajo:

Capítulo 1. Antecedentes.

En este capítulo se hace una breve descripción del Instituto de Ingeniería y su misión, pues es donde se realizó la

implementación del cluster. También se muestran los antecedentes del proyecto OpenMosix y los cambios que ha tenido

en sus diferentes etapas.

Capítulo 2. Conceptos básicos de cómputo científico y clusters.

En este capítulo se describen conceptos fundamentales detrás del cómputo con clusters y se da una respuesta a la

pregunta: ¿Por qué emplear Clusters?. También se cubren algunos conceptos básicos implicados en cómputo paralelo, optimización de programas, tecnologías de red elementales y de OpenMosix como un cluster de alto desempeño y balanceo de carga, mostrando sus características y capacidades. Esto permite trabajar con un vocabulario común en el resto del trabajo de tesis.

Capítulo 3. Análisis para el diseño del cluster OpenMosix.

En este capítulo se hace un estudio de los recursos en cuanto a requerimientos ideales básicos para la construcción de un cluster,

como el que se plantea en este proyecto: características de los nodos, de la red de computadoras, requerimientos

de hardware, requerimientos de software, características de la distribución Linux, de los compiladores y de las herramientas de administración.

Capítulo 4. Diseño del cluster OpenMosix.

En el capítulo tres se hace la descripción ideal para el cluster, ahora se plantea el diseño y organización del cluster

de acuerdo al equipo de cómputo disponible para la construcción del mismo.

Capítulo 5. Implementación del cluster OpenMosix.

Se describe la instalación de los nodos y su configuración, la instalación de compiladores y la seguridad lógica

del cluster.

Capitulo 6. Administración del cluster.

Se analizan y describen algunas de las herramientas para la administración del cluster y para el monitoreo de procesos

distribuidos en los nodos de cluster.

Capitulo 7. Desempeño y pruebas de rendimiento.

Se muestran resultados de pruebas generales de rendimiento del cluster con ejecución de programas de propósito general,

y en particular con programas de investigadores del Instituto de Ingeniería de las coordinaciones de Ingeniería

Sismológica y Mecánica Aplicada.

Antecedentes

Instituto de Ingeniería

El Instituto de Ingeniería de la UNAM

El Instituto de Ingeniería es parte del Subsistema de Investigación Científica de la Universidad Nacional Autónoma de

México y orgánicamente se encuentra dentro de la Coordinación de la Investigación Científica.

En la Universidad Nacional Autónoma de México, el Instituto de Ingeniería es el centro de investigación en diversas

áreas de la ingeniería más productivo del país. Es una comunidad de aproximadamente 900 personas, entre ellos investigadores,

estudiantes de ingeniería que realizan trabajos de tesis de licenciatura, maestría y doctorado, técnicos académicos,

personal secretarial y de servicios.

Desde su fundación en 1956![[*]](footnote.png) , la política del Instituto ha sido realizar investigación orientada a problemas generales de

la ingeniería, así como colaborar con entidades públicas y privadas para mejorar la práctica de la ingeniería en el ámbito nacional, al aplicar los resultados de las investigaciones a problemas específicos.

, la política del Instituto ha sido realizar investigación orientada a problemas generales de

la ingeniería, así como colaborar con entidades públicas y privadas para mejorar la práctica de la ingeniería en el ámbito nacional, al aplicar los resultados de las investigaciones a problemas específicos.

En los programas actuales de trabajo se enfatiza el interés en las necesidades de la ingeniería nacional.

Las actividades que se llevan a cabo en el Instituto son: investigación técnica y aplicada, apoyo al desarrollo tecnológico y análisis de los requerimientos sociales a cuya solución puede aportar la ingeniería. Asimismo, se proporcionan servicios de ingeniería a los diversos sectores de la sociedad con el propósito de contribuir al avance de los objetivos propios de la Universidad.

Las principales funciones del Instituto son:

- Realizar investigación para mejorar los conocimientos, métodos y criterios en ingeniería, tanto fundamental como

aplicada.

- La formación de investigadores en ingeniería.

- Apoyar el desarrollo tecnológico y análisis de los requerimientos sociales a cuya solución puede aportar la

ingeniería.

- Proporcionar servicios de ingeniería a los diversos sectores de la sociedad con el propósito de contribuir al

avance de los objetivos propios de la Universidad.

- Apoyar la formación de profesores y las tareas docentes de la Facultad de Ingeniería.

- Estudiar problemas de interés nacional.

- Difundir los resultados de sus investigaciones.

- Llevar a cabo las actividades necesarias para realizar las funciones precedentes.

En el desempeño de estas funciones, el Instituto colabora con otras instituciones afines, técnicas, culturales y

científicas del país y en el extranjero.

Áreas de investigación

A continuación se mencionan las áreas de investigación que comprende el Instituto de ingeniería,

como lo muestra el organigrama de la figura ![[*]](crossref.png) .

.

- Automatización

- Bioprocesos Ambientales

- Estructuras y Materiales

- Geotecnia

- Hidráulica

- Ingeniería Ambiental

- Ingeniería de Procesos Industriales y Ambientales

- Ingeniería de Sistemas

- Ingeniería Mecánica Térmica y de Fluidos

- Ingeniería Sismológica

- Instrumentación

- Mecánica Aplicada

- Sismología e Instrumentación Sísmica

- Sistemas de Cómputo

- Vías Terrestres

Antecedentes del proyecto OpenMosix

OpenMosix es un proyecto de software libre para la implementación de un cluster de alto desempeño y balanceo de carga.

Primero fue el proyecto Mosix, el cual en un inicio se liberó mediante una licencia de software libre, que permitía

la libre distribución y modificación del código fuente de este proyecto; posteriormente los desarrolladores de Mosix

deciden cambiar su licencia por una que impedía la modificación y adaptación del código fuente a las necesidades de quien

usara este software. Debido a tal situación, varias personas que trabajaban en el proyecto decidieron separarse de él y

continuar con el desarrollo bajo un esquema de software libre, el cual hace participar a una gran comunidad

involucrada en el tema de clusters con Linux. El resultado es el proyecto OpenMosix.![[*]](footnote.png)

Conceptos básicos de cómputo científico y clusters

En este capítulo se tratan algunos de los conceptos fundamentales detrás del cómputo con clusters, conceptos

básicos implicados en cómputo científico, optimización de programas y algunos de tecnologías de red básicos.

Esto permite al lector trabajar con un vocabulario común cuando se comience con el tema del diseño, instalación

y configuración del cluster.

Cómputo científico

Cómputo científico:

Se entiende por cómputo científico el desarrollo y traducción en términos de tecnología de cómputo para procesar modelos computacionales, cuya finalidad es resolver problemas complejos de ciencia e ingeniería

![[*]](footnote.png) .

.

El cómputo científico usa como parte principal la modelación matemática y/o computacional. Cuando se

resuelve un problema complejo, mediante el uso de la computadora, también se le denomina experimentación numérica, la cual se considera otra rama para aprender y obtener información nueva, que se suma a las otras metodologías tradicionales: teoría y experimentación.

Cluster

Un cluster es un arreglo de computadoras conectadas por una red para trabajar en cierto gran problema que pueda

ser resuelto en pequeños pedazos [HDavid00].

Las características principales de un cluster [MCatalan04] son:

Un cluster consta de 2 o más nodos.

Un cluster consta de 2 o más nodos.

Los nodos del cluster están conectados entre sí por al menos un canal de comunicación.

Los nodos del cluster están conectados entre sí por al menos un canal de comunicación.

Los clusters necesitan software de control especializado.

Los clusters necesitan software de control especializado.

Otro concepto importante es clustering, que se refiere a la técnica que permite combinar múltiples

sistemas para trabajar en conjunto, y que se comporten como un recurso informático unificado. Implica proveer

niveles de disponibilidad y escalabilidad de un sistema al menor costo.

Conceptos básicos

Alto rendimiento: Gran demanda de procesamiento de datos en procesadores, memoria y otros recursos de hardware,

donde la comunicación entre ellos es rápida.

Balanceo de carga:

Lo ideal en el procesamiento paralelo es que cada procesador realice la misma cantidad de trabajo, donde además se espera

que los procesadores trabajen al mismo tiempo. La meta del balanceo de carga es minimizar el tiempo de espera de los procesadores en los puntos de sincronización.

Compilador:

Un compilador es un programa que traduce otro programa escrito en un lenguaje de programación llamado código fuente,

en un programa equivalente al lenguaje de computadora llamado ejecutable ó binario.

Computadora vectorial:

Posee un conjunto de unidades funcionales utilizados para procesar vectores eficientemente. Contiene registros vectoriales para operar sobre ellos en un solo ciclo de reloj.

Computadora paralela: Máquina con dos o más procesadores que pueden trabajar simultánea y/o coordinadamente.

Estas son de dos tipos: las MIMD donde cada procesador puede ejecutar diferentes instrucciones sobre diferentes datos, y las

SIMD donde los procesadores ejecutan las mismas instrucciones pero con diferentes datos, como se explicara en la siguiente sección.

Eficiencia:

Es la relación entre el costo computacional y el funcionamiento del cluster; y lo que indica es qué tan eficiente se está utilizando el hardware y se expresa de la siguiente forma:

![]() ; donde

; donde ![]() es la eficiencia,

es la eficiencia,![]() es el numero de procesadores,

es el numero de procesadores, ![]() es el tiempo en que tarda en procesar un programa en particular en un procesador,

es el tiempo en que tarda en procesar un programa en particular en un procesador,

![]() es el tiempo en que tarda en procesar un programa en particular en n procesadores.

es el tiempo en que tarda en procesar un programa en particular en n procesadores.

Escalabilidad:

Generalmente se mide la eficiencia de un problema, utilizando un tamaño y un número

de procesadores fijo, pero esto es insuficiente, pues los resultados serán diferentes cuando se aumente

o disminuya el tamaño del problema y el número de procesadores. Esto es, existe un problema de

escalabilidad.

Cuando se aumenta el número de procesadores para el mismo tamaño del problema, la

sobrecarga debido al paralelismo (comunicaciones, desbalanceo de carga), aumenta y similarmente

podemos tener casos en donde el tamaño del problema es muy pequeño para tener una evaluación real

del problema sobre cierta máquina.

Flops:

Un flop es utilizado para medir operaciones de punto flotante por segundo. Es una medida de la velocidad del

procesamiento numérico del procesador. Se utilizan en unidades de millones de flops (MegaFlops), Miles de Millones de flops (GigaFlops), etc.

Kernel:

El kernel, también conocido como núcleo; es la parte fundamental de un sistema operativo. Es el software responsable

de facilitar a los distintos programas acceso seguro al hardware de la computadora.

Memoria compartida:

En una máquina paralela existe una sola memoria que puede ser accedida por todos los procesadores.

Memoria distribuida:

Cada uno de los procesadores de un multiprocesador tiene asociado a él una unidad de memoria.

Nodo:

Se refiere a una computadora sola que contiene recursos específicos, tales como memoria,

interfaces de red, uno o más CPU, etc.

Paralelismo:

Consiste en el procesamiento de una serie de instrucciones de programa que son ejecutables por múltiples procesadores

que trabajan de manera independiente [MCatalan04]

.

Existen dos formas conocidas de hacer paralelismo: una es en hardware y otra en software. Por hardware depende de la tecnología de cómputo y la de software se refiere a la habilidad del usuario para encontrar áreas bien definidas del problema que se desea resolver, de tal forma que éste pueda ser dividido en partes que serán distribuidas entre los nodos del cluster.

Proceso:

Un proceso es básicamente un programa en ejecución. Cada proceso tiene asociado un espacio de direcciones, es decir una

lista de posiciones de memoria desde algún mínimo hasta algún máximo que el proceso puede leer y escribir [ATanenbaum03].

Rendimiento:

Es la efectividad del desempeño de una computadora sobre una aplicación o prueba de rendimiento (benchmark)

en particular. En las mediciones de rendimiento están involucrados velocidad, costo y eficiencia.

Speedup(velocidad):

Se define como el tiempo que tarda en ejecutarse el mismo programa en un solo procesador, dividido entre el tiempo que

toma ejecutarse el mismo programa en ![]() procesadores.

procesadores.

![]() .

.

Donde ![]() es el speedup,

es el speedup, ![]() es el tiempo de ejecución en un procesador y

es el tiempo de ejecución en un procesador y ![]() el tiempo de ejecución en

el tiempo de ejecución en ![]() procesadores.

procesadores.

En un problema que es completamente paralelo, el valor del speedup debe ir incrementando linealmente con el valor de ![]() ,

sin embargo en muchos problemas donde el balanceo de carga no es perfecto y la comunicación entre procesos sobrepasa

el tiempo de cómputo, el valor del speedup es menor que el valor de

,

sin embargo en muchos problemas donde el balanceo de carga no es perfecto y la comunicación entre procesos sobrepasa

el tiempo de cómputo, el valor del speedup es menor que el valor de ![]() . La mejor solución es la que se acerque más

al valor de

. La mejor solución es la que se acerque más

al valor de ![]()

Lenguajes de programación paralela

Existen varios lenguajes de programación paralela, sobresaliendo de estos MPI(Message Passing Interface) y PVM(Parallel Virtual Machine),

por ser uno de los estándares más aceptados.

MPI

MPI consiste de una biblioteca estándar para programación paralela en el modelo de intercambio de mensajes.

En este estándar se han incluido los aspectos más relevantes de otras bibliotecas de programación paralela.

Entre las ventajas de MPI se encuentra la disponibilidad de varios modos de comunicación, los cuales permiten

al programador el uso de buffers para el envío rápido de mensajes cortos, la sincronización de procesos o el traslape

de procesos de cómputo con procesos de comunicación. Esto último reduce el tiempo de ejecución de un programa paralelo,

pero tiene la desventaja de que el programador debe ser más cuidadoso para evitar la corrupción de mensajes.

Dos de las principales distribuciones libres de MPI son: LAM/MPI y MPICH.

PVM

PVM se comenzó a desarrollar en el verano de 1989 por el Oak Ridge National Laboratory, y posteriormente junto con

la Universidad de Tennessee en los EUA. Es una biblioteca de envío de mensajes, totalmente libre, capaz de trabajar

en redes homogéneas y heterogéneas, y que hace uso de los recursos existentes en algún centro de trabajo para poder

construir una máquina paralela de bajo costo, obteniendo su mejor rendimiento en ``horas muertas''.

Maneja transparentemente el ruteo de todos los mensajes, conversión de datos y calendarización

de tareas a través de una red de arquitecturas incompatibles. Está diseñado para conjuntar

recursos de cómputo y proveer a los usuarios de una plataforma paralela para correr sus aplicaciones,

independientemente del número de computadoras distintas que utilicen y donde éstas se encuentren

localizadas. El modelo computacional de PVM es simple y además muy general. El usuario escribe su

aplicación como una colección de tareas cooperativas. Las tareas acceden los recursos de PVM a través

de una biblioteca de rutinas. Estas rutinas permiten la inicialización y terminación de tareas a

través de la red, así como la comunicación y sincronización entre tareas.

Los constructores de comunicación incluyen aquellos para envío y recepción de estructuras de datos así como primitivas de alto nivel, tales como emisión, barreras de sincronización y sumas globales.

Tipos y modelos de clusters

En esta sección se analizan los tipos y modelos de cluster basados en la taxonomía de Flynn.

Arquitecturas de computadoras

En 1966 Michael Flynn propuso un mecanismo de clasificación de las computadoras. La taxonomía de Flynn es la manera clásica de organizar las computadoras, y aunque no cubre todas las posibles arquitecturas, proporciona una importante visión para varias de éstas.

El método de Flynn se basa en el número de instrucciones y de la secuencia de datos que la computadora utiliza para procesar información. Puede haber secuencias de instrucciones sencillas o múltiples y secuencias de datos sencillas o múltiples. Dicha clasificación da lugar a cuatro tipos de computadoras (figura ![[*]](crossref.png) ):

):

- SISD : Single Instruction Single Data

- SIMD : Single Instruction Multiple Data

- MIMD : Multiple Instruction Multiple Data

- MISD : Multiple Instruction Single Data

Los modelos SIMD y MIMD son los únicos modelos aplicables a las computadoras paralelas. También hay que mencionar que el modelo MISD es teórico.

SISD

SISD es el modelo tradicional de computadora secuencial donde una unidad de procesamiento recibe una sola secuencia de instrucciones que opera en una secuencia de datos, ejemplo: para procesar la suma de N números

![]() , el procesador necesita acceder a memoria

, el procesador necesita acceder a memoria ![]() veces consecutivas (para recibir un número). También son ejecutadas en

secuencia N-1 sumas, es decir los algoritmos para las computadoras SISD no contienen ningún paralelismo, éstas están

construidas de un solo procesador (figura

veces consecutivas (para recibir un número). También son ejecutadas en

secuencia N-1 sumas, es decir los algoritmos para las computadoras SISD no contienen ningún paralelismo, éstas están

construidas de un solo procesador (figura ![[*]](crossref.png) ).

).

SIMD

A diferencia de SISD, en el modelo SIMD se tienen múltiples procesadores que sincronizadamente ejecutan la misma secuencia de instrucciones, pero en diferentes datos (figura ![[*]](crossref.png) ). El tipo de memoria que estos sistemas utilizan es distribuida,

ejemplo: aquí hay

). El tipo de memoria que estos sistemas utilizan es distribuida,

ejemplo: aquí hay ![]() secuencias de datos, una por procesador, por lo que diferentes datos pueden ser utilizados en

cada procesador. Los procesadores operan sincronizadamente y un reloj global se utiliza para asegurar esta operación,

es decir, en cada paso todos los procesadores ejecutan la misma instrucción, cada uno con diferente dato, ejemplo:

sumando dos matrices

secuencias de datos, una por procesador, por lo que diferentes datos pueden ser utilizados en

cada procesador. Los procesadores operan sincronizadamente y un reloj global se utiliza para asegurar esta operación,

es decir, en cada paso todos los procesadores ejecutan la misma instrucción, cada uno con diferente dato, ejemplo:

sumando dos matrices ![]() , siendo

, siendo ![]() y

y ![]() de orden 2 y teniendo 4 procesadores.

de orden 2 y teniendo 4 procesadores.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.5] A11 + B11 = C11 , A12 + B12 = C12 A21 + B21 = C21 , A22 + B22 = C22

La misma instrucción se ejecuta en los 4 procesadores (sumando dos números) y los 4 ejecutan las instrucciones

simultáneamente. Esto toma un paso en comparación con cuatro pasos en máquina secuencial.

Máquinas con arreglos de procesadores vectoriales como CRAY1 y CRAY2 son ejemplos de arquitecturas SIMD.

MIMD

El modelo MIMD es del tipo de computadoras paralelas al igual que las SIMD. La diferencia con estos sistemas

es que MIMD es asíncrono: no tiene un reloj central (figura ![[*]](crossref.png) ).

).

Cada procesador en un sistema MIMD puede ejecutar su propia secuencia de instrucciones y tener sus propios datos: esta

característica es la más general y poderosa de esta clasificación.

Se tienen ![]() procesadores,

procesadores, ![]() secuencias de instrucciones y

secuencias de instrucciones y ![]() secuencias de datos. Cada procesador opera bajo el control de una secuencia de instrucciones, ejecutada por su propia unidad de control, es decir cada procesador es capaz de ejecutar su propio programa con diferentes datos. Esto significa que los procesadores operan asincrónicamente, o en términos simples, pueden estar haciendo diferentes cosas en diferentes datos al mismo tiempo.

secuencias de datos. Cada procesador opera bajo el control de una secuencia de instrucciones, ejecutada por su propia unidad de control, es decir cada procesador es capaz de ejecutar su propio programa con diferentes datos. Esto significa que los procesadores operan asincrónicamente, o en términos simples, pueden estar haciendo diferentes cosas en diferentes datos al mismo tiempo.

Los sistemas MIMD también tienen una subclasificación:

- Sistemas de memoria compartida:

En este tipo de sistemas cada procesador tiene acceso a toda la memoria, es decir, hay un espacio de direccionamiento compartido (figura

![[*]](crossref.png) ). Con esto se tiene tiempo de acceso a memoria uniformes, ya que todos los procesadores se encuentran igualmente comunicados con memoria principal, además el acceso a memoria es por medio de un solo canal. En esta configuración debe asegurarse que los procesadores no tengan acceso simultáneamente a regiones de memoria de una manera en la que pueda ocurrir algún error.

). Con esto se tiene tiempo de acceso a memoria uniformes, ya que todos los procesadores se encuentran igualmente comunicados con memoria principal, además el acceso a memoria es por medio de un solo canal. En esta configuración debe asegurarse que los procesadores no tengan acceso simultáneamente a regiones de memoria de una manera en la que pueda ocurrir algún error.

Ventajas:

- Facilidad de la programación. Es mucho más fácil programar en estos sistemas que en sistemas de memoria distribuida.

- Las computadoras MIMD con memoria compartida son sistemas conocidos como de multiprocesamiento simétrico (SMP), donde múltiples procesadores comparten un mismo sistema operativo y memoria. Otro término con que se conoce es máquinas firmemente juntas o de multiprocesadores.

Desventajas:

- El acceso simultáneo a memoria es un problema.

- Poca escalabilidad de procesadores, debido a que se puede generar un cuello de botella en el número de CPU.

- En computadoras vectoriales como la Cray, todas las CPU tienen un camino libre a la memoria. No hay diferencia entre las CPU.

- La razón principal por el alto precio de Cray es la memoria.

Algunos ejemplos de estos sistemas son: SGI/Cray Power Challenge, SGI/Cray C90, SGI/Onyx, ENCORE, MULTIMAX, SEQUENT y BALANCE, entre otras.

- Sistemas de memoria distribuida:

Estos sistemas tienen su propia memoria local. Los procesadores pueden compartir información solamente enviando mensajes, es decir, si un procesador requiere los datos contenidos en la memoria de otro procesador, deberá enviar un mensaje solicitándolos (figura

![[*]](crossref.png) ). A esta comunicación se le conoce como paso de mensajes.

). A esta comunicación se le conoce como paso de mensajes.

Ventajas:

- La escalabilidad. Las computadoras con sistemas de memoria distribuida son fáciles de escalar, debido a la demanda de los recursos se puede agregar más memoria y procesadores.

Desventajas:

- El acceso remoto a memoria es lento.

- La programación puede ser complicada.

Las computadoras MIMD de memoria distribuida son conocidas como sistemas de procesamiento en paralelo (MPP), donde múltiples procesadores trabajan en diferentes partes de un programa, usando su propio sistema y memoria. También se les llama multicomputadoras, máquinas libremente juntas o cluster.

MISD

El modelo MISD no tiene una aplicación real, pero se hace la descripción teórica. En este modelo, secuencias de instrucciones pasan a través de múltiples procesadores. Diferentes operaciones son realizadas en diversos procesadores, es decir, ![]() procesadores, cada uno con su propia unidad de control, comparten una memoria común (figura

procesadores, cada uno con su propia unidad de control, comparten una memoria común (figura ![[*]](crossref.png) ).

).

Aquí hay ![]() secuencias de instrucciones y una secuencia de datos. El paralelismo es alcanzado dejando que los procesadores realicen cosas al mismo tiempo en el mismo dato.

secuencias de instrucciones y una secuencia de datos. El paralelismo es alcanzado dejando que los procesadores realicen cosas al mismo tiempo en el mismo dato.

Tipos de clusters

Los clusters se pueden clasificar tomando en cuenta diferentes aspectos como la aplicación, disponibilidad, servicio, hardware, sistema operativo, configuración y el número de nodos.

Para cuestiones prácticas, en este trabajo se tomó en cuenta la siguiente clasificación con respecto al servicio que proveen los cluster:

- Tolerante a fallas (Fail-Over): Utiliza una conexión de alto desempeño entre las computadoras; ésta conexión es utilizada para monitorear cuál(es) de los servicios están en uso, así como la sustitución de una máquina por otra cuando uno de sus servicios ha caído.

- Balanceo de carga (Load-Balancing): Cuando los recursos del nodo son insuficientes para el procesamiento de los datos, el cluster distribuye entre los demás nodos las tareas para un mejor desempeño.

- Alto Desempeño (High Performance Computing): Estas máquinas han estado configuradas especialmente para centros de datos que requieren una potencia de computación extrema.

Modelos de clusters

- NUMA (Non-Uniform Memory Access): Tiene acceso compartido a la memoria donde se puede ejecutar el código del programa.

- MPI (Message Passing Interface): Es el estándar abierto de librerías de paso de mensajes. MPICH y LAM (Local Area Multicomputer) son dos implementaciones de MPI de código abierto.

- PVM (Parallel Virtual Machine): Al igual que MPI, también es usado en clusters Beowulf y se basa en paso de mensajes, aunque ya está cayendo en desuso, pues carece de varias características y no cumple con los nuevos estándares para desarrollo de programas paralelos.

- Beowulf: Es un cluster de componentes commodity

![[*]](footnote.png) dedicados a la solución de un problema paralelo. El primer cluster de este tipo fue desarrollado por Thomas Sterling, de la división de Ciencias de la Tierra de la NASA en JPL California. Esta solución popular ha sido ampliamente aceptada en varios ambientes de producción, principalmente laboratorios de investigación y sitios académicos.

dedicados a la solución de un problema paralelo. El primer cluster de este tipo fue desarrollado por Thomas Sterling, de la división de Ciencias de la Tierra de la NASA en JPL California. Esta solución popular ha sido ampliamente aceptada en varios ambientes de producción, principalmente laboratorios de investigación y sitios académicos.

En una configuración tradicional de un cluster Beowulf, los nodos se conectan por medio de una red privada, y sólo el nodo maestro es visible desde el exterior. El nodo maestro está reservado para acceder, compilar y manejar las aplicaciones a ejecutar.

OpenMosix como un cluster de alto desempeño y balanceo de carga

En la sección 2.3 se ha hablado de los tipos y modelos de clusters. Aquí describiremos las características de OpenMosix para entender su funcionamiento y la utilidad de éste.

OpenMosix es un parche (patch) al kernel de Linux que proporciona compatibilidad con el estándar de Linux versión 2.4.x para plataformas IA32![[*]](footnote.png) [MCatalan04], el algoritmo interno de balanceo de carga migra los procesos entre los nodos del cluster de forma transparente para el usuario. La principal ventaja es una mejor compartición de los recursos entre nodos, así como un mejor aprovechamiento de los mismos.

[MCatalan04], el algoritmo interno de balanceo de carga migra los procesos entre los nodos del cluster de forma transparente para el usuario. La principal ventaja es una mejor compartición de los recursos entre nodos, así como un mejor aprovechamiento de los mismos.

El cluster OpenMosix asigna por sí mismo la utilización óptima de los recursos que son necesarios en cada momento y de forma automática, y a esto nos referimos cuando decimos que el balanceo de carga es transparente al usuario, pues éste no necesita preocuparse por hacer uso de algunas tareas o herramientas extra para poder trabajar en este sistema.

Los algoritmos de OpenMosix son dinámicos, lo que contrasta y es una fuerte ventaja frente a los algoritmos estáticos de PVM/MPI. Responde a las variaciones en el uso de los recursos entre los nodos, migrando procesos de un nodo a otro, con

y de forma transparente para el proceso para balanceo de carga y para evitar falta de memoria en un nodo, no necesita una adaptación de la aplicación, ni siquiera que el usuario sepa algo sobre el cluster.

OpenMosix puede balancear una única aplicación, si esta está dividida en procesos. Esto ocurre en gran número de

aplicaciones hoy en día: lo que balancea son procesos. Cuando un nodo está muy cargado por sus procesos y otro no,

se migran procesos del primer nodo al segundo.

La característica de migración de procesos transparente hace que el cluster funcione de forma ``similar'' a un sistema SMP(Symmetric Multi Processing), donde las tareas originadas en un nodo del cluster pueden distribuirse en los diferentes ``procesadores'' de este sistema.

El proyecto OpenMosix está respaldado y siendo desarrollado por personas muy competentes y respetadas en el mundo del Open Source, trabajando juntas en todo el mundo, tratando de crear un estándar en el entorno de clustering para todo tipo de aplicaciones HPC (High Performance Computing).

Características de OpenMosix

Pros de OpenMosix:

- No se requieren paquetes extra.

- No son necesarias modificaciones en el código.

Contras de OpenMosix:

- Es dependiente del kernel.

- No migra todos los procesos siempre, tiene limitaciones de funcionamiento.

- Problemas con memoria compartida.

Además los procesos con múltiples threads (hilos) no ganan demasiada eficiencia.

Tampoco se obtiene mucha mejora cuando se ejecuta un solo proceso, como por ejemplo un navegador web.

Subsistemas de OpenMosix

Actualmente podemos dividir los parches de OpenMosix en cuatro grandes subsistemas.

- Mosix File System (MFS):

En cuanto a líneas de código el primer subsistema es MFS que permite un acceso a sistemas de archivos remotos, por ejemplo, como si estuviese localmente montado.

El sistema de archivos del nodo raíz y de los demás podrán ser montados en el directorio

y se podrán acceder por ejemplo: para acceder al

y se podrán acceder por ejemplo: para acceder al  del nodo 2 dentro del directorio

del nodo 2 dentro del directorio

desde cualquier nodo del cluster.

desde cualquier nodo del cluster.

- Migración de procesos:

Con OpenMosix se puede lanzar un proceso en una computadora y ver si se ejecuta en ésta, en otra, o en el seno del cluster (nodo maestro).

Cada proceso tiene su único nodo raíz (UHN, Unique Home Node) que corresponde con el que lo ha generado.

El concepto de migración significa que un proceso se divide en dos partes: la parte del usuario y la del sistema. La parte, o área de usuario, será movida al nodo remoto mientras el área de sistema espera en el raíz. Mientras tanto OpenMosix se encarga de establecer la comunicación entre estos dos procesos.

- Direct File System Access(DFSA):

OpenMosix proporciona MFS con la opción DFSA, que permite acceso a todos los sistemas de archivos tanto locales como remotos.

- Memory Ushering:

Este subsistema se encarga de migrar las tareas que superan la memoria disponible en el nodo en el que se ejecutan. Las tareas que separan dicho límite se migran forzosamente a un nodo destino de entre los nodos del cluster que tengan suficiente memoria como para ejecutar el proceso sin necesidad de hacer swap a disco, ahorrando así la gran pérdida de rendimiento que esto supone.

El subsistema de memoria ushering es un subsistema independiente del subsistema de equilibrado de carga, y por ello se le considera por separado.

El algoritmo de migración

El proceso de migración basado en el modelo

![]()

![[*]](footnote.png) , en el que puede migrarse cualquier proceso a cualquier nodo del cluster de forma completamente transparente. La migración también puede ser automática: el algoritmo que lo implementa tiene una complejidad del orden de

, en el que puede migrarse cualquier proceso a cualquier nodo del cluster de forma completamente transparente. La migración también puede ser automática: el algoritmo que lo implementa tiene una complejidad del orden de ![]() , siendo

, siendo ![]() el número de nodos del cluster [MCatalan04].

el número de nodos del cluster [MCatalan04].

La ventaja del modelo es que la distribución de tareas en el cluster está determinada por OpenMosix de forma dinámica, conforme se van creando tareas. Así, cuando un nodo está demasiado cargado y las tareas que se están ejecutando puedan migrar a cualquier otro nodo del cluster. Es así como desde que una tarea se ejecuta hasta que ésta termina, podrá migrar de un nodo a otro, sin que el proceso sufra mayores cambios.

El nodo raíz:

Cada proceso ejecutado en el cluster tiene asignado un único nodo raíz, en el cual se lanza originalmente el proceso y donde éste empieza a ejecutarse.

Desde el punto de vista del espacio de procesos de la maquina del cluster, cada proceso con su correspondiente Identificador de Proceso (PID) parece ejecutarse en su nodo raíz. El nodo de ejecución puede ser el nodo raíz u otro diferente, hecho que da lugar a que el proceso no use un PID del nodo de ejecución si no que el proceso migrado se ejecutara en este como una ![]() (hebra o hilo) del kernel. La interacción con un proceso, por ejemplo enviarle señales a cualquier proceso migrado, se puede realizar exclusivamente del nodo raíz.

(hebra o hilo) del kernel. La interacción con un proceso, por ejemplo enviarle señales a cualquier proceso migrado, se puede realizar exclusivamente del nodo raíz.

Por otra parte la migración y el retorno al nodo raíz de un proceso se puede realizar tanto desde el nodo raíz como desde el nodo dónde se ejecuta el proceso. Esta tarea la puede llevar el administrador de cualquiera de los dos sistemas.

El mecanismo de migrado

La migración de procesos en OpenMosix es completamente transparente. Esto significa que al proceso migrado no se le avisa que ya no se ejecuta en su nodo de origen, y si tuviera que leer o escribir algo, lo haría en el nodo origen, hecho que supone leer o grabar remotamente en este nodo.

¿Cúando podrá migrar un proceso?

Desgraciadamente, no todos los procesos pueden migrar en cualquier circunstancia. El mecanismo de migración de procesos puede operar sobre cualquier tarea de un nodo sobre el que se cumplen algunas condiciones predeterminadas, estas son:

- El proceso no puede ejecutarse en modo de emulación VM86 (Modo Virtual 8086), donde se requieren ejecutar instrucciones antiguas para procesadores de arquitectura 8086.

- El proceso no puede ejecutar instrucciones en ensamblador propias de la máquina donde se lanza y que no tiene la máquina destino (en un cluster heterogéneo).

- El proceso no puede mapear memoria de un dispositivo a la RAM, ni acceder directamente a los registros de un dispositivo.

- Y una condición muy importante: el proceso no puede usar segmentos de memoria compartida.

Cumpliendo todas estas condiciones el proceso puede migrar y ejecutarse migrado. Como se puede sospechar OpenMosix no sabe nada de esto y en un principio migra todos los procesos que puedan hacerlo si por el momento cumple todas las condiciones, y en caso de que algún proceso deje de cumplirlas, lo devuelve al nodo raíz para que se ejecute en él mientras no pueda migrar de nuevo.

Comunicación entre las dos áreas

Un aspecto interesante es cómo se realiza la comunicación entre el área de usuario y el área de kernel.

En algún momento, el proceso migrado puede necesitar hacer alguna llamada al sistema. Esta llamada se captura y se evalúa:

- Si puede ser ejecutada al nodo al que la tarea ha migrado, o

- Si necesita ser lanzada en el nodo raíz del proceso migrado

Si la llamada puede ser lanzada al nodo donde la tarea migrada se ejecuta, los accesos al kernel se hacen de

forma local, es decir, que se atiende en el nodo donde la tarea se ejecuta sin ninguna carga adicional a la red.

Por desgracia, las llamadas más comunes son las que se han de ejecutar forzosamente al nodo raíz, puesto

que se comunican con el hardware. Es el caso, por ejemplo, de una lectura o una escritura a disco. En este caso el

subsistema de OpenMosix del nodo donde se ejecuta la tarea contacta con el subsistema de OpenMosix del nodo

raíz. Para enviarle la petición, así como todos los parámetros y los datos del nodo raíz que necesitara procesar.

El nodo raíz procesará la llamada y enviara de vuelta al nodo dónde se esta ejecutando realmente el proceso migrado cualquiera de estos datos:

- El valor del éxito o fracaso de la llamada.

- Aquello que necesite saber para actualizar sus segmentos de datos.

- El estado en el que estará si el proceso se ejecuta en el nodo raíz.

Esta comunicación también puede ser generada por el nodo raíz. Es el caso, por ejemplo, del envió de una

señal. El subsistema de OpenMosix del nodo raíz contacta con el subsistema de OpenMosix del nodo dónde el

proceso migrado se ejecuta, y él avisa que ha ocurrido un evento asíncrono. El subsistema de OpenMosix del nodo

dónde el proceso migrado se ejecuta parará el proceso migrado y el nodo raíz podrá empezar a atender el código

del área del kernel que corresponderá a la señal asíncrona.

Finalmente, una vez realizada toda la operación necesaria del área del kernel, el subsistema de

OpenMosix del nodo raíz del proceso envía al nodo donde está ejecutándose realmente el proceso migrado, el

aviso detallado de la llamada y todo aquello que el proceso necesita saber (anteriormente enumerado) cuando

recibió la señal, y el proceso migrado finalmente recuperará el control.

Por todo esto el proceso migrado es como si estuviera al nodo raíz y hubiera recibido la señal de éste.

Tenemos un escenario muy simple donde el proceso se suspende esperando un recurso. Recordemos que la

suspensión esperando un recurso se produce únicamente en área de kernel. Cuando se pide una página de disco o

se espera un paquete de red se resuelve como en el primer caso comentado, es decir, como una llamada al kernel.

Este mecanismo de comunicación entre áreas es el que nos aseguran que:

- La migración sea completamente transparente tanto para el proceso que migra como para los procesos que cohabiten con el nodo raíz.

- Que el proceso no necesite ser reescrito para poder migrar, ni sea necesario conocer la topología del cluster para escribir una aplicación paralela.

No obstante, en el caso de llamadas al kernel que tengan que ser enviadas forzosamente al nodo raíz, tendremos una sobrecarga adicional a la red debida a la transmisión constante de las llamadas al kernel y la recepción de sus valores de vuelta.

Destacamos especialmente esta sobrecarga en el acceso a sockets y el acceso a disco duro, que son las dos

operaciones mas importantes que se habrán de ejecutar en el nodo raíz y suponen una sobrecarga al proceso de comunicación entre la área de usuario migrada y la área de kernel del proceso migrado.

Análisis para el diseño del cluster OpenMosix

Como se habló en la sección 2.4, la distribución de procesos en los nodos del cluster es la principal característica de funcionalidad de OpenMosix. De una forma ideal, los procesos buscarán ejecutarse en un ambiente igual o muy similar del nodo donde provienen, tal vez con mejores recursos de memoria y procesador. Hablando en términos del programa, éste estará ejecutándose en nodos externos, por lo que es indispensable que el procesador externo tenga el conjunto de instrucciones necesarias para poder procesar el código compilado en el nodo anfitrión, de otra forma el programa no podría ejecutarse.

Con base en estas observaciones, se concluye que la construcción de un cluster OpenMosix como en otros tipos de clusters es muy recomendable que se haga con hardware homogéneo, aunque muchas de las veces debido a los recursos con los que se pueden disponer en nuestro centros de investigación no es posible cumplir con este requerimiento, no indispensable pero si recomendado, pues además de proveer un ambiente de ejecución adecuado para los procesos, facilita la administración del software instalado en los nodos del cluster.

Requerimientos de Hardware

La elección del hardware a utilizar en un cluster puede definirse primeramente en base a conocer la magnitud del problema o problemas que se quieren resolver, el hardware que puede adquirirse en el mercado, los recursos económicos y humanos con los que se cuentan, tanto para administrar el cluster cómo para programar y ejecutar las aplicaciones. Cuando se planea la adquisición, se propone la compra del ``mejor'' equipo de cómputo.

La descripción de estos nodos es una propuesta ideal para ensamblar el cluster, en ésta también se describe el tipo de red o canal de comunicación que se recomienda, aunque por supuesto es hardware que cumple con los requerimientos básicos. Cabe aclarar que no se propone la construcción de un cluster especifico, pues no se ensamblará éste para un propósito, problema o proyecto en particular, si no por el contrario, el cluster que se ha propuesto es para la ejecución de programas de propósito general que ya existen o se usan dentro del Instituto de Ingeniería, o de aquellos que pueden ser adaptados con cierta facilidad a este tipo de ambientes. En el capítulo 7, en las pruebas de rendimiento se mostrará la utilidad de OpenMosix y el tipo de programas que pueden aprovechar ésta tecnología y cuales no.

En las coordinaciones donde se desarrolló este trabajo se ejecutan programas con diferentes tipos de requerimientos, por tanto se propondrá el diseño de un cluster que pueda en el mayor de los casos responder a las necesidades generales.

Características de los nodos

Se identifican como nodos aquellas unidades individuales de procesamiento en el cluster. Para la implementación de un cluster OpenMosix, el hardware soportado es para las arquitecturas IA32 y compatibles, es decir, en términos del hardware disponible en el mercado estamos hablando de los procesadores Intel y AMD con tecnología para procesamiento de palabras de 32 bits. OpenMosix ha sido desarrollado y probado para funcionar en estos dos tipos de procesadores y como se ha mencionado ya, es recomendable no ensamblar clusters con ambos tipos de procesadores.

Los factores en la elección de uno u otro tipo de procesador son principalmente su costo y también por supuesto el software que se podrá aprovechar al máximo. Como ejemplo, se puede mencionar que por cuestiones de mercado, los procesadores AMD han sido más económicos sin querer decir con esto que tengan un menor rendimiento o tecnologías más obsoleta o atrasada, pero en cuanto al desarrollo de aplicaciones de software comerciales y no comerciales, como por ejemplos los compiladores, estas han sido desarrolladas y optimizadas para los procesadores Intel. Esto no quiere decir que sea imposible de implementar un cluster de bajo costo con hardware de bajo costo, simplemente se requiere en la mayoría de los casos un estudio de las herramientas disponibles para optimizar las aplicaciones de los usuarios.

Con base en estas observaciones se hace una propuesta de equipo de cómputo ideal, pensando en que la adquisición de este equipo es exclusivamente para el uso de un cluster dedicado.

- Procesador:

Intel(R) Pentium (R) 4.

Velocidad del procesador (Processor Speed) 3.6 GHz.

Cache Nivel 2 (L2) de 2 MB.

- Memoria (RAM):

2 GB DDR-2 667 MHz.

- Disco Duro (Hard Disk):

120 GB, SCSI de 15,000 rpm.

- Tarjeta Madre (Motherboard)

Intel Corporation.

Velocidad del Bus (System Bus Speed) 800 MHz.

Velocidad de la memoria (System Memory Speed) 667 MHz.

- Tarjeta de red

Intel Gigabit Ethernet.

Se ha listado el hardware básico de forma ilustrativa, pues no se mencionan detalles como dispositivos periféricos (teclado, mouse, etc.) y tarjetas adicionales (tarjeta SCSI para los discos duros, etc.), éstas quedan a criterio de las necesidades reales que se les puedan dar a estos dispositivos en el cluster.

Características de la red de computadoras

Como se ha venido mencionando, el canal de comunicación es uno de los subsistemas más importantes en la construcción de un cluster, pues de este dependen todo tipo de comunicaciones que haya entre los nodos. Cuando no se tiene el conocimiento sobre la importancia de éste, el tener la última tecnología en cuanto a procesadores no ayuda en nada al cluster, pues la comunicación entre ellos echa por la borda el trabajo de cooperación que pudieran tener de una forma eficiente.

En el mercado, desde la aparición de las redes de computadoras han surgido diversos tipos de tecnologías. Las más destacadas por su bajo costo relativo y la facilidad de uso e implementación son las redes Ethernet. Aunque una red de este tipo no siempre satisface las necesidades de comunicación veloz de un cluster, por el costo y la reutilización de las redes ya instaladas se hace casi siempre uso de éstas.

En ésta propuesta, considerando que las redes tipo Ethernet se hacen cada vez más accesibles por la reducción de costos, se considera implementar Gigabit Ethernet. En el caso OpenMosix, es el tipo de red de computadoras más veloz con el que se conoce puede trabajar, pues aunque existen tecnologías de red mucho más veloces, el kernel y el tipo de comunicaciones con las que trabaja OpenMosix, no están programadas para aprovecharlas aún.

Requerimientos de Software

El fin que lleva a la construcción de un cluster es por supuesto la ejecución de algún programa, entonces es de suma importancia conocer que tipo de software que se debe y se puede instalar para que las tareas que se ejecuten lo hagan con el mejor desempeño posible.

Características de la distribución Linux

Una alternativa importante para atender soluciones a ciertas demandas de cómputo científico se deriva de componentes de software libre, como el sistema operativo Linux; el proyecto que originó todos los derivados actuales de clusters. Principalmente por que es de código abierto, su código fuente esta disponible para poder adaptarlo a distintos ambientes de hardware y software, entre otras características. Derivado de esto, varios grupos han desarrollado lo que se les conoce como distribuciones de Linux. Como es conocido, existe una gran variedad de distribuciones, y muchas de estas pueden ser tomadas como base para poder implementar un cluster OpenMosix.

La elección de la distribución para implementar un cluster OpenMosix depende de factores básicos como lo es el software con el que cuenta la distribución, el soporte a actualizaciones para todo este tipo de software, las herramientas de administración del sistema, su facilidad de uso y aprendizaje entre otros.

Para el proyecto OpenMosix, de acuerdo con la documentación y foros de discusión de usuarios de ésta tecnología, las distribuciones más utilizadas son Red Hat, Debian, Suse y Gentoo. Todas ellas utilizadas por su gran reputación en el mercado, facilidad de uso y estabilidad.

Características de los compiladores

Dentro de las aplicaciones finales que serán ejecutadas en el cluster, tenemos dos casos a saber:

- Aquellas que por ser aplicaciones comerciales o de terceros no se dispone del código fuente.

- Aquellas de las que sí se dispone del código fuente.

Para que las primeras puedan aprovechar el cluster OpenMosix, sólo es necesario revisar que cumplan con los requisitos que se han mencionado en la sección 2.4.5.

Para los programas que se generará un ejecutable a partir del código fuente, el compilador es una pieza muy importante, pues aunque pareciera ser trivial, no todos los compiladores hacen optimizaciones de la misma calida. Esto quiere decir que un compilador puede generar un código objeto o también llamado ejecutable que puede ser ejecutado más eficientemente y con mayor velocidad en la misma arquitectura del procesador donde se trabaja.

Dependiendo del programa que se compile y del tipo de resultados que se desea obtener en cuanto a velocidad de ejecución, es la decisión en el uso de uno u otro compilador. También en esta decisión influye conjuntamente el costo monetario de la adquisición del compilador.

En proyectos de cómputo científico pequeños, para programas en lenguaje C o Fortran, la mayoría de las veces basta con el compilador de software libre como GNU/GCC y librerías de programación como PVM y LAM/MPI, que también son software libre. En otros casos, por el tipo de proyecto, es conveniente gastar en la adquisición de compiladores comerciales como los que vende Intel y Portran Group entre otros. Estos compiladores como se ha mencionado tienen la capacidad de hacer optimizaciones muy fuertes, además de proveer en la mayoría de los casos herramientas para depurar el código.

Herramientas de administración

Además de las herramientas de administración de procesos y sistemas de archivos locales con las que cuentan todas las distribuciones de Linux, se hace necesario la utilización de otras herramientas para la administración y el monitoreo de los procesos distribuidos en el cluster. Estas herramientas tendrán la tarea de reportar:

- El estado actual de los procesos.

- El estado actual de la carga de cada nodo del cluster.

- El estado actual de tráfico de red.

- El estado actual de los sistemas de archivos distribuidos si se cuenta con ellos.

- Resultados parciales del proceso o procesos en ejecución.

Cada tipo de cluster y dependiendo de las aplicaciones y software que se utilice, hace uso de herramientas que faciliten tareas como las listadas anteriormente. En el caso de un cluster OpenMosix, éste posee un conjunto de herramientas llamadas User Land Tools, éstas son las herramientas básicas que nos ayudan en la administración básica de los procesos que se distribuyen en los nodos así como de su supervisión. En los siguientes capítulos se habla con más detalle sobre el uso de éstas.

Diseño del cluster OpenMosix

En este capítulo se describen los componentes de hardware y de software que componen el cluster OpenMosix antes de comenzar con el procedimiento de instalación.

Para este diseño se tomaron en cuenta los mejores equipos y de igual arquitectura con los que se cuenta para obtener un mejor rendimiento de las aplicaciones.

Organización de los nodos

Hardware

Nodo maestro: Este nodo se eligió por tener el mejor procesador de las computadoras disponibles, tomando en cuenta que los demás fueran de la misma arquitectura.

Las principales características son:

- Procesador:

Intel(R) Pentium (R) 4.

Velocidad del procesador (Processor Speed) 2.8 GHz.

Cache Nivel 2 (L2) de 512 KB.

- Memoria (RAM):

512 MB DDR 400 MHz.

- Disco Duro (Hard Disk):

Segate ST31200022A 120 GB, IDE de 7,200 rpm.

- Tarjeta Madre (Motherboard)

Intel Corporation D865GLC.

Velocidad del Bus (System Bus Speed) 800 MHz.

Velocidad de la memoria (System Memory Speed) 400 MHz.

- Tarjeta de red

Intel (R) Pro/100 Network Conecction.

Fast Ethernet.

Nodos esclavos: Los tres nodos esclavos son casi idénticos al nodo principal, la única diferencia radica en la velocidad del procesador que es menor a la del nodo maestro.

Las principales características de estos nodos son:

- Procesador:

Intel(R) Pentium (R) 4.

Velocidad del procesador (Processor Speed) 2.4 GHz.

Cache Nivel 2 (L2) de 512 KB.

- Memoria (RAM):

512 MB DDR 400 MHz.

- Disco Duro (Hard Disk):

Segate ST38001A 80 GB, IDE de 7,200 rpm.

- Tarjeta Madre (Motherboard):

Intel Corporation D865GBF.

Velocidad del Bus (System Bus Speed) 800 MHz.

Velocidad de la memoria (System Memory Speed) 400 MHz.

- Tarjeta de red:

Intel (R) Pro/100 Network Conecction

Fast Ethernet

Software

Sistema Operativo:

Suse 9.0 con kernel OpenMosix 2.4.24: Distribución de Linux que soporta versiones de kernels 2.4.x compatible con openMosix, además de ser la distribución que se utiliza para servidores y estaciones de trabajo de los usuarios en el Instituto de Ingeniería.

Sistema de archivos:

Reiserfs: Sistema de archivo utilizado para las particiones Linux, que al igual que el sistema de archivos ext3, incluye la característica de journaling que previene el riesgo corrupciones del sistema de archivos y es de los más utilizados por presentar mejor desempeño en el manejo de archivos.

Mosix File System (MFS): Necesario en OpenMosix para proveer de acceso al sistema de archivos remotos y que ayuda a mantener la consistencia de cache.

Herramientas de administración

- User Lan Tools: Las herramientas de área de usuario son lo mínimo que necesita cualquier administrador o usuario de OpenMosix para el manejo de los procesos.

- OpenMosixView: Aplicación gráfica de monitoreo de OpenMosix, con ella puede realizarse parte de las tareas comunes que se harían con los comandos de las User Lan Tools.

Estas herramientas para administrar, supervisar y migrar los procesos en el cluster OpenMosix se describen en detalle en el capítulo seis.

Descripción de la conexión de los nodos

En esta sección se da una descripción de la topología de la red y de los componentes de la conexión entre nodos del cluster, como son el switch y el cable de red utilizados. Cabe mencionar que esta configuración es parte de la red actual del Instituto de Ingeniería.

Topología

La topología de red utilizada es la estrella, se caracteriza por tener todos sus nodos conectados a un controlador central, en este caso, un switch de 48 nodos de los cuales 4 nodos pertenecen al cluster. Todas las comunicaciones pasan a través del switch, siendo éste el encargado de controlarlas. Por este motivo, el fallo de un nodo en particular es fácil de detectar y no daña el resto de la red, pero un fallo en el controlador central desactiva la red completa.

Switch

El switch es marca 3Com SuperStack 3, serie 4400.

Una característica importante es que soporta telefonía sobre IP y tiene rendimiento de ancho de banda de 13.6 Gbps (forwarding bandwidth) y 10.1 millones de paquetes por segundo.

El switch es de 48 nodos y también soporta tráfico de telefonía o también llamado VoIP, tecnología con que cuenta el Instituto de Ingeniería, a la cual se le da mayor prioridad cuando es necesario.

Los equipos conectados a este switch se conectan a una velocidad auto negociable de 10Base-T/100Base-TX, según la tarjeta de red.

Cuenta con un puerto Gigabit 1000 Base SX para salir a otro equipo: 3Com 7700, que es el que provee de red ethernet a la Torre de Ingeniería, donde se encuentra físicamente el cluster, como lo muestra la figura 4.1.

Cable

El cable con el que están conectados los nodos del cluster al switch que los une, es estructurado de la marca Kron categoría 6, para velocidades de transmisión de datos Ethernet 10/100/1000.

Tarjetas de red

Las tarjetas de red con que cuenta cada nodo, son las especificadas anteriormente, todas estas marca Intel, e integradas a las tarjetas madre.

Implementación del cluster OpenMosix

Conociendo la terminología básica sobre clusters y habiendo formulado un diseño específico con OpenMosix, ahora se plantea la forma en que se lleva a cabo la implementación.

Instalación de los nodos

De una forma práctica, en este capítulo se explica la instalación de Suse Linux 9.0 de forma breve, puesto que se hace mayor énfasis en la instalación de OpenMosix.

Descripción de particiones del disco duro:

Los nodos con los que se trabajó son compartidos, es decir se utilizan tanto en ambientes Windows como en Linux y no son de uso exclusivo del cluster. En cada nodo se tiene instalado Windows XP Profesional, Suse Linux 9.3 Profesional y se instaló Suse Linux 9.0 Profesional para configurar el cluster OpenMosix, todo en un mismo disco duro, particionado de la siguiente forma para el nodo maestro y de manera similar para los nodos esclavos:

- 80 GB con Windows XP Profesional SP2 con un sistema de archivos NTFS.

- 1 GB con swap (Memoria de intercambio virtual) para Linux.

- 30 GB con Linux Suse 9.3 Profesional con un sistema de archivos reiserfs.

- 6 GB con Linux Suse 9.0 Profesional con un sistema de archivos reiserfs.

Se muestra con mayor detalle esta configuración con ayuda del comando fdisk:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # fdisk -l Device Boot Start End Blocks Id System /dev/hda1 * 1 10199 81923436 7 HPFS/NTFS /dev/hda2 10200 10329 1044225 82 Linux swap /dev/hda3 10330 13853 28306530 83 Linux /dev/hda4 13854 14592 5936017+ 83 Linux

Las primeras tres particiones son de uso particular de los usuarios de las computadoras utilizadas, la cuarta partición es la que se usa para la instalación y configuración de OpenMosix.

Instalación de Suse 9.0

Se hace la instalación estándar a través de red con el CD número uno de instalación y la herramienta de instalación y administración Yast ![[*]](footnote.png) la cual nos guiará haciendo las particiones necesarias, y se instalan los módulos de los controladores necesarios según el hardware con el que se cuenta; se utiliza como fuente de instalación el espejo (mirror) http://linux.iingen.unam.mx, donde se cuenta con los archivos fuente de instalación; también se puede hacer ésta con los 5 CDs de instalación de Suse 9.0.

la cual nos guiará haciendo las particiones necesarias, y se instalan los módulos de los controladores necesarios según el hardware con el que se cuenta; se utiliza como fuente de instalación el espejo (mirror) http://linux.iingen.unam.mx, donde se cuenta con los archivos fuente de instalación; también se puede hacer ésta con los 5 CDs de instalación de Suse 9.0.

Configuración de la red

Se hizo una configuración estática de direcciones IP, mascara de red, gateway y DNS para una red privada; en este caso, la configuración elegida fue de uso exclusivo del cluster, pues los usuarios de estos equipos no la usan para acceso a recursos de red, como impresiones, trabajo en grupo o Internet.

Actualizaciones (patchs) del sistema

La actualización de los paquetes instalados se hace utilizando la herramienta YOU (Yast On Line Update), necesario para mantener seguro el sistema. Esta actualización se hace también por medio de la red del espejo mencionando.

Configuración de los nodos

En los nodos esclavos sólo se instala el kernel OpenMosix, las User Lan Tools y se configuran los nodos para que arranquen en nivel 3 (multiusuario sin modo gráfico) para mejorar el rendimiento de éstos en el cluster, pues no necesitan un ambiente gráfico para las aplicaciones de ventanas.

En el nodo maestro se instala el kernel OpenMosix, las User Lan Tools y las herramientas adicionales de administración y monitoreo (OpenMosixView); se configura para que arranque en nivel 5 (modo gráfico) y poder aprovechar las herramientas de monitoreo.

Compilación del kernel OpenMosix

Ésta es la parte central del trabajo. Aquí se describe la forma de instalar el kernel o núcleo con el que funciona OpenMosix.

Comenzamos con la instalación del kernel openmosix-kernel-source-2.4.24-OpenMosix2.i386.rpm que soporta el sistema de archivos MFS.

- Se instalan los archivos fuente de OpenMosix con los parches incluidos, los cuales aún no están compilados:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # rpm -ivh OpenMosix-kernel-source-2.4.24-OpenMosix2.i386.rpm

El código fuente al instalar este rpm, lo coloca en /usr/src/linux-2.4.24-OpenMosix2, por lo que hay que cambiarse a esa ruta.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # cd /usr/src/linux-2.4.24-OpenMosix2

- Es en este momento cuando se procede con la compilación del kernel OpenMosix, limpiando los archivos de código objeto obsoletos que pudieran encontrarse:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # make mrproper

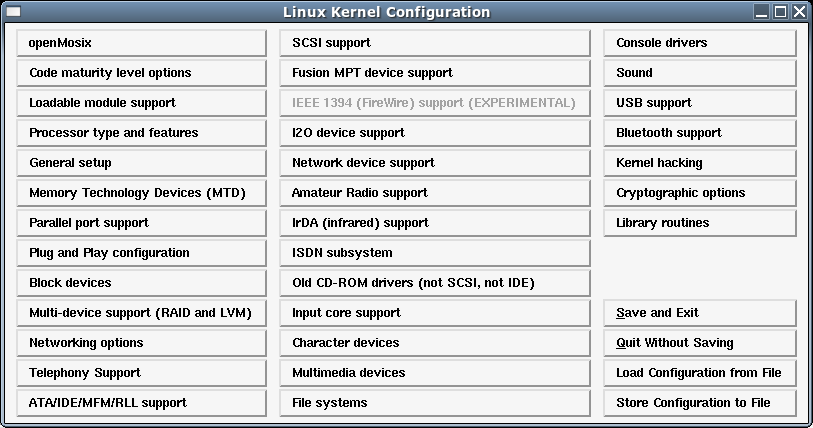

- Se configuran las opciones de compilación del kernel basándose en el archivo de configuración de un kernel de Suse 9.0 precompilado, es decir, con el que ya se está trabajando, pues en este archivo se listan todos los módulos para que nuestro nodo funcione adecuadamente.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # make xconfig

- Se personaliza de acuerdo al hardware con el que se cuenta, y si es necesario, se quitan los módulos del hardware con el que no se cuenta y se asegura que se encuentren seleccionados los módulos del hardware de los equipos utilizados (figura

![[*]](crossref.png) ).

).

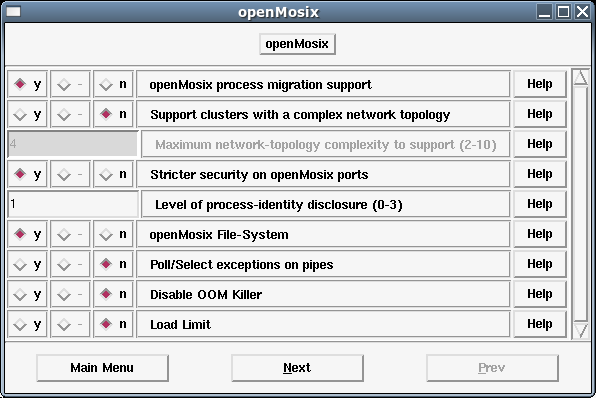

- Se habilita el trabajo del kernel con OpenMosix y el Sistema de archivos OpenMosix File-System (

![[*]](crossref.png) ).

).

- Se resuelven las dependencias de todos los módulos seleccionados para compilarse en el kernel.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # make dep

- Se crea(compila) el rpm

![[*]](footnote.png) del nuevo kernel con OpenMosix.

del nuevo kernel con OpenMosix.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # make rpm

Instalación del kernel

Una vez compilado el kernel se comienza con su instalación.

- Se instala el rpm creado con el siguiente comando:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # rpm -ivh /usr/src/packages/RPMS/i586/kernel-2.4.24OpenMosix2-1.i586.rpm

- Se crea el initrd para el kernel OpenMosix compilado, necesario para el correcto arranque del sistema.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # mkinitrd

- Se configura Grub (Sistema gestor de arranque de Suse 9.0) para arrancar con el nuevo kernel OpenMosix, con una configuración como la siguiente en el archivo /boot/grub/menu.lst.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] title Cluster OpenMosix 2.4.24 kernel (hd0,3)/boot/vmlinuz-2.4.24-OpenMosix2 root=/dev/hda4\ vga=0x31a splash=silent desktop hdc=ide-scsi hdclun=0 showopts initrd (hd0,3)/boot/initrd-2.4.24-OpenMosix2

- Se agrega la siguiente línea al archivo /etc/fstab para dar de alta el sistema de archivos MFS, tomando en cuenta que el directorio /mfs ya fue creado anteriormente:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # vi /etc/fstab mfs_mnt /mfs mfs dfsa=1 0 0

Instalación de las User Land Tools

Una vez instalado el kernel se procede a instalar las herramientas de administración User Land Tools; como requisito, es necesario tener instaladas las librerías ncurses, contenidas en los CDs de instalación de Suse 9.0.

- Se crea el rpm, que es equivalente a compilar las Herramientas de Administración (User Lan Tools), y para esto nos cambiamos al directorio /usr/src:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # cd /usr/src/

- Se crea una liga simbólica, necesaria para la correcta compilación de estos códigos fuente.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # ln -s linux-2.4.24-OpenMosix2 linux-OpenMosix

- Nos cambiamos al directorio donde se tienen el código fuente de las User Land Tools.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # cd /root/srcCluster/toolsOM

- Se construye el rpm, equivalente a compilar las librerías, y de esta manera se resuelven dependencias entre paquetes.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # rpmbuild --rebuild OpenMosix-tools-0.3.6-2.src.rpm

- Se instala el rpm creado.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # rpm -ivh /usr/src/packages/RPMS/i586/OpenMosix-tools-0.3.6-2.i586.rpm

Instalación de OpenMosixView

Instaladas las herramientas de usuario, se procede a instalar las herramientas de monitoreo OpenMosixView:

- Instalación por medio del paquete rpm.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # cd /root/srcCluster/toolsOM # rpm -ivh openmosixview-1.5-redhat90.i386.rpm

Esta versión precompilada se obtuvo del sitio de internet http://www.openmosixview.com/ donde es mantenido este proyecto.

Configuración de OpenMosix

Después de terminar con la instalación del kernel y de las herramientas, procedemos a configurar el cluster.

- Se configura el archivo /etc/openmosix.map en el cual se listan los nodos pertenecientes al cluster, para esto, se necesita editar este archivo y agregar a la lista cada uno de los nodos, quedando de la siguiente forma:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # vi /etc/openmosix.map 1 192.168.1.1 1 2 192.168.1.2 1 3 192.168.1.3 1 4 192.168.1.4 1

Como se observa, la primera columna enumera las direcciones IP de los nodos que pertenecen al cluster (columna dos) y la última columna indica el número consecutivo de nodos que pueden pertenecer al cluster, pudiendo con esto hacer abreviaciones de configuración, es decir, la configuración anterior podría haberse escrito de la siguiente manera:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # vi /etc/openmosix.map 1 192.168.1.1 4

Prueba mínima de funcionamiento

Una vez terminada la configuración del cluster, sólo resta hacer una prueba de funcionamiento. Con el siguiente script en bash shell podemos hacer esta prueba. El funcionamiento de esta se basa en la ejecución de 10 tareas simultaneas. El programa no tiene ningún fin práctico, sólo es para probar la migración de los procesos en el cluster.

Para ejecutar el siguiente script, se escribe este código en un archivo llamado pruebaOM.sh y se ejecuta.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3]

#!/bin/bash

#-------------------------------------------------------

# DESCRIPCION: Script que lanza 10 tareas simultaneas.

# Cada tarea itera en un ciclo doble de 10000 unidades.

# El objetivo es probar que el cluster esta migrando las

# tareas a los demás nodos

#-------------------------------------------------------

for x in 1 2 3 4 5 6 7 8 9 10

do

awk 'BEGIN {for(i=0;i<10000;i++)for(j=0;j<10000;j++);}' &

done

Para poder observar si los procesos están migrando, se utiliza el comando mosmon:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] # mosmon

Instalación de los compiladores

Ahora se describe la instalación del compilador Intel, recordando que ya tenemos el compilador de código libre GNU/GCC, y que sin él no habríamos podido compilar los paquetes antes mencionados. Cabe mencionar que además del compilador comercial Intel existen otros como LAHEY y Portran Group.

Se instala el compilador de Intel debido a que es el que adquirieron investigadores del instituto, al observar algunas ventajas de este sobre GNU/GCC, LAHEY y el de Portran Group.

Compilador Intel

- Una vez obtenido este compilador se descomprime el paquete l_fc_p_9.0.021.tar.gz:

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] linux:~/Intel # gunzip l_fc_p_9.0.021.tar.gz linux:~/Intel # tar -xvf l_fc_p_9.0.021.tar linux:~/Intel # cd l_fc_p_9.0.021

- Para obtener detalles sobre el producto y la instalación leemos el manual de instalación.

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] linux:~/Intel/l_fc_p_9.0.021 # more INSTALL.txt

- Ahora se comienza con la instalación.

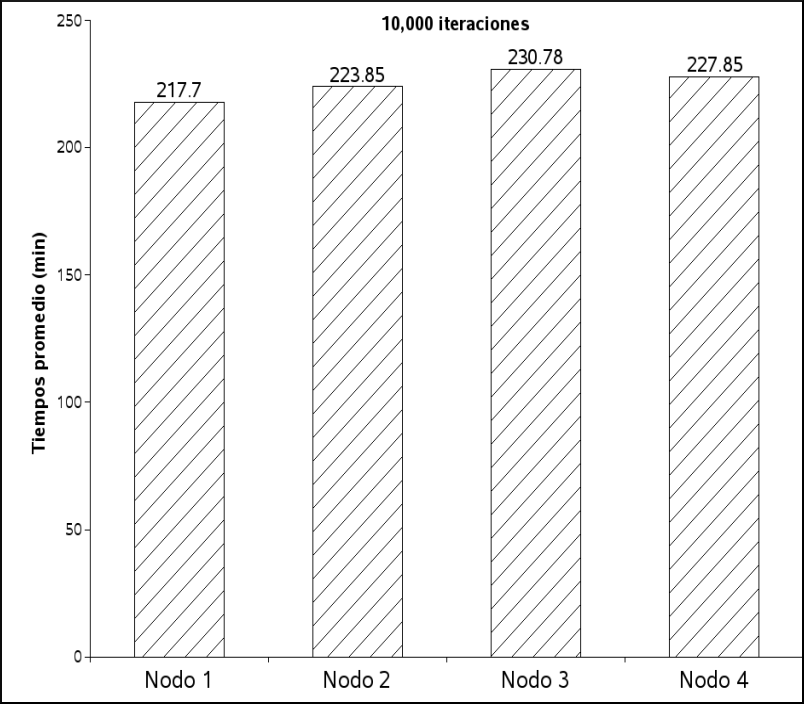

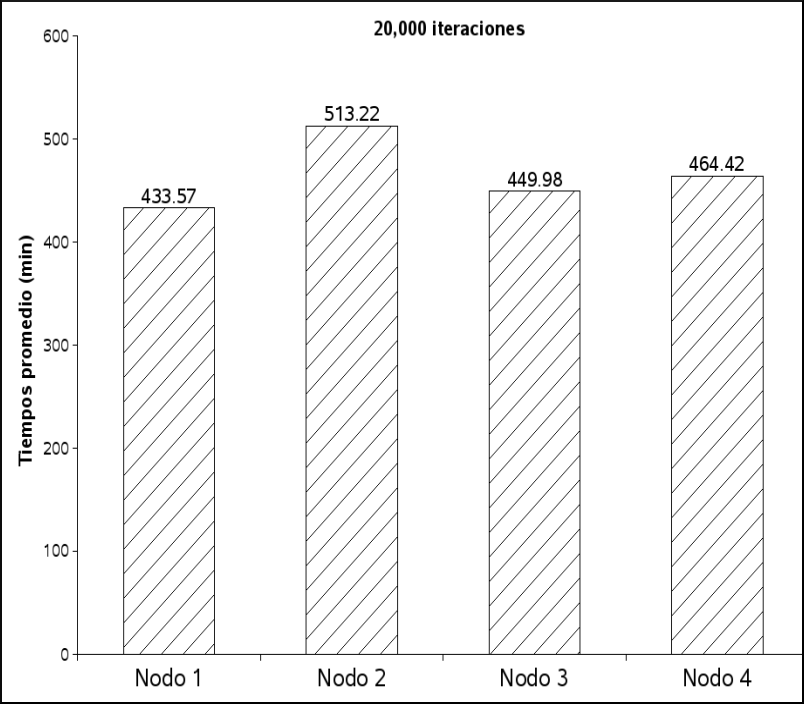

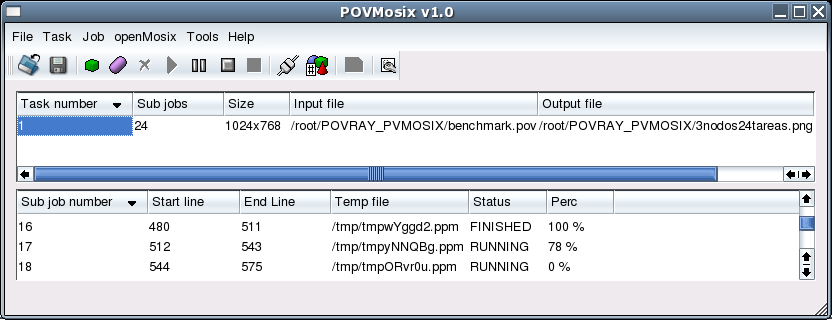

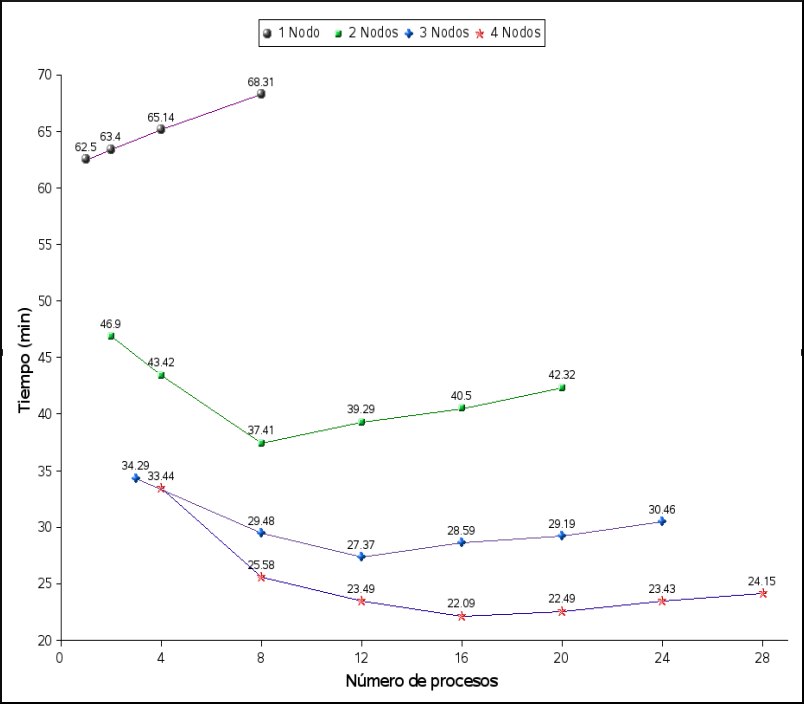

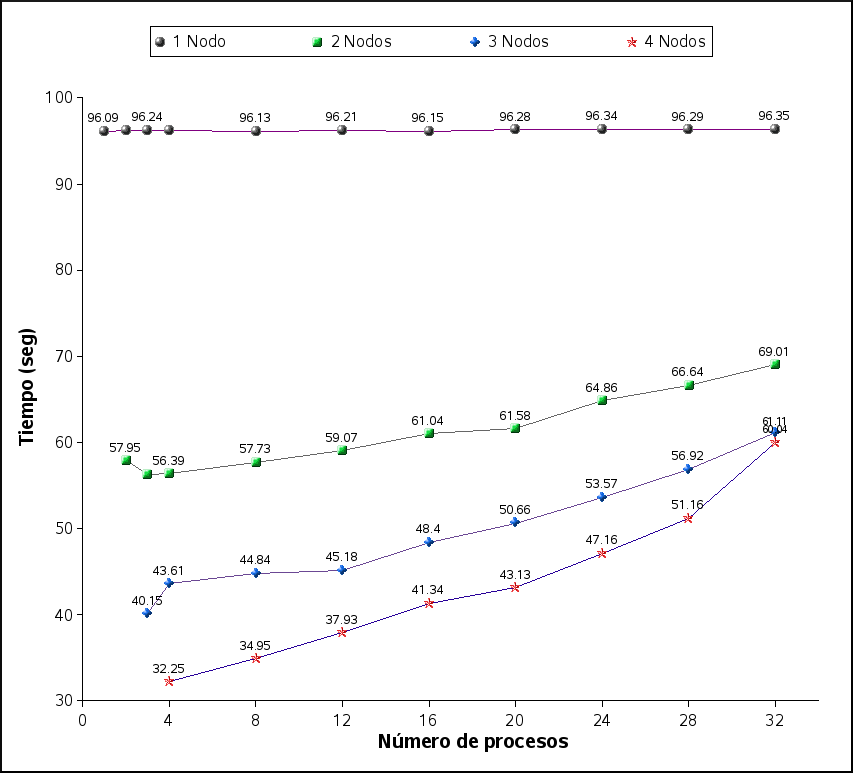

[fontfamily=courier,fontshape=it,fontsize=\small,baselinestretch=0.3] linux:~/Intel/l_fc_p_9.0.021 #./install.sh